Any Model・Any Accelerator・Any Cloud

|

「vLLM 正在成為生成式 AI 推論領域的 Linux」 |

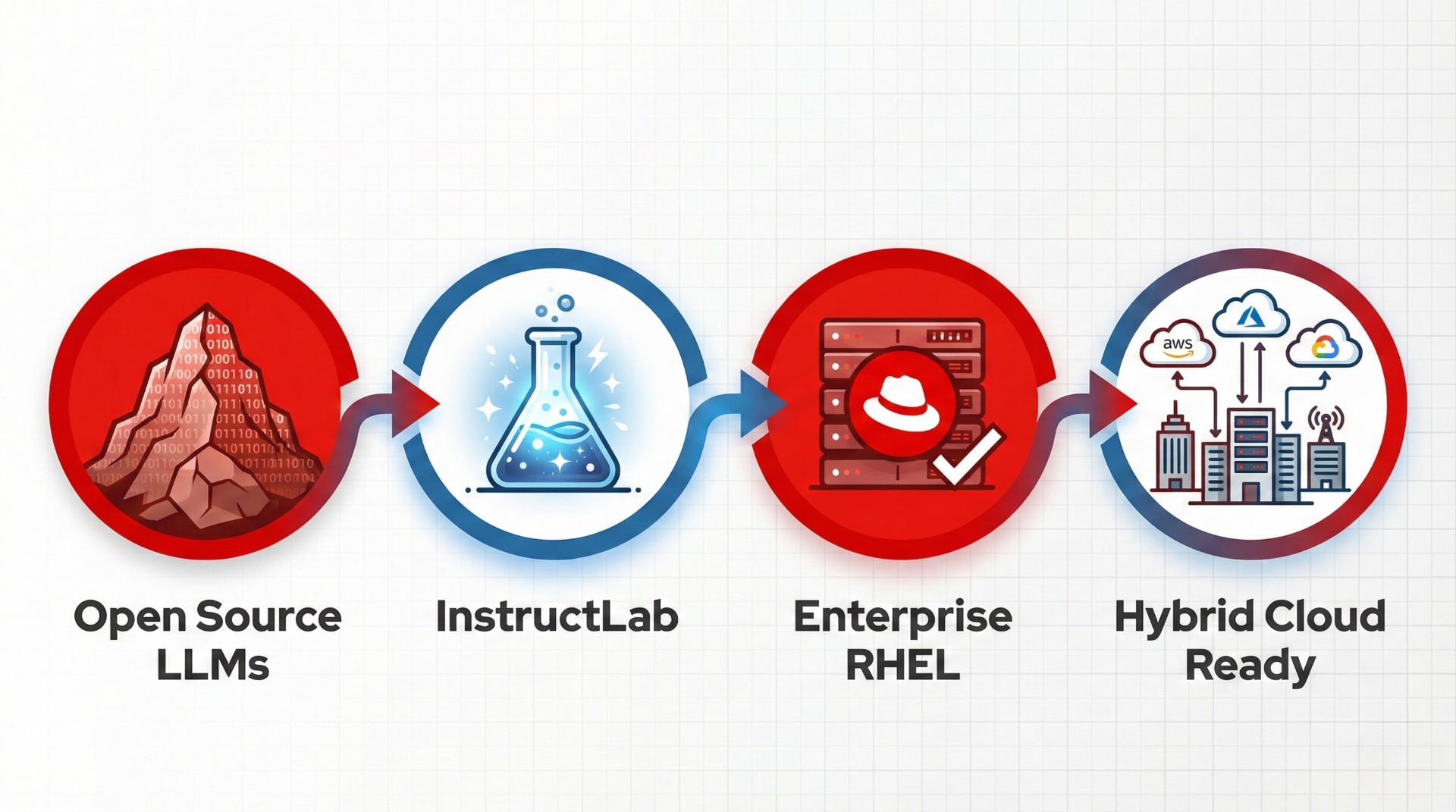

Red Hat Enterprise Linux AI 是一個專為企業打造的生成式 AI 推論平台。簡單來說,它就像是 AI 模型的「高效能執行環境」——讓您的 AI 模型能夠在企業級的 Linux 環境中穩定、快速、安全地運行。

想像一下:您的企業已經選定了適合的 AI 模型(例如 Llama、Mistral、Qwen 等),現在需要一個可靠的平台來部署和運行這些模型,提供服務給內部系統或客戶。RHEL AI 正是為此而生。

🚀 高效能推論 |

💰 成本優化 |

🔧 簡化部署 |

|

基於 vLLM 的 AI Inference Server,最大化 GPU 使用效率 |

內建模型壓縮工具,大幅降低運算資源需求 |

採用 Bootc 容器技術,一鍵部署完整 AI 運行環境加快部署與環境安全性 |

這是 RHEL AI 的「引擎」,負責實際運行 AI 模型並處理推論請求。它基於業界領先的開源專案 vLLM,能夠智慧地管理 GPU 記憶體、同時處理多個請求,讓您的硬體投資發揮最大效益。

生成式 AI 模型通常體積龐大,因此需要大量 GPU 記憶體來運行。這個工具包就像是「模型瘦身專家」,提供兩種優化方式:

透過工具可以大幅降低模型需要的 GPU 資源並且維持近乎相同於原本模型的精準度。

對於不需要自己客製化與壓縮模型的使用者,紅帽亦提供已優化且驗證過的開源預訓練模型,可直接於 Hugging Face 平台下載使用,大幅縮短從部署到上線的時程。

RHEL AI 以穩定可靠的企業級 RHEL 為基石,導入創新的 Image Mode 管理模式。透過 Bootc 技術,將整個作業系統(包含 Kernel 核心、GPU 驅動程式與 AI 執行環境)封裝為標準容器鏡像。這讓維運人員能像管理容器一樣,對「作業系統本身」進行精準的版本控制、原子化更新與大規模一致性部署。

|

項目 |

傳統部署 |

Bootc 部署 |

|

安裝步驟 |

安裝 OS → 設定 → 安裝驅動 → 安裝框架 → 部署模型 |

下載映像 → 開機 → 完成 |

|

更新方式 |

逐一更新套件,可能產生相容性問題 |

整個映像原子性替換,確保一致性 |

|

套件安裝方式 |

Yum / Dnf |

Containerfile |

|

回滾機制 |

複雜,需要備份和手動還原 |

原生支援,一鍵切換至前一版本 |

|

環境一致性 |

可能因設定差異產生漂移 |

映像即真相,每次部署完全相同 |

RHEL AI 支援多種主流開源模型,均已針對 vLLM 進行優化驗證:

|

模型系列 |

來源 |

|

Llama 3.x |

Meta |

|

Mistral / Mixtral |

Mistral AI |

|

Qwen 2.5 |

Alibaba Cloud |

|

DeepSeek |

DeepSeek AI |

|

Gemma |

|

RHEL AI 特別適合以下企業情境:

|

目前 REHL 1.5 最新版本將於 2025 年 12 月 13 日 End of Life,未來版本將以 3.0 版本為主。3.0 版本是架構性的重大變更,更加專注於推論功能,不再包含 InstructLab 模型微調工具。 |

您是否想評估您的企業目前的混合雲自動化成熟度?或希望進一步了解 Red Hat Ansible 在實際 IT 營運場景的作用?MetaAge 邁達特是 Red Hat 台灣總代理,擁有近 30 年雲地整合、混合多雲治理的實戰經驗。邁達特不僅提供產品授權,更專精於規劃、導入與客製化您的 Ansible 策略,確保自動化效益能在您的 IT 環境中真正落地並持續擴展。

您可由此填寫 【免費諮詢表單】聯繫邁達特顧問團隊,讓邁達特的 Ansible 認證工程師為您量身打造以自動化為核心的雲端治理策略,助您掌握混合雲管理全局。